La science augmentée

L’intelligence artificielle est entrée dans le quotidien des chercheurs. Révolution scientifique ou simple outil, elle offre des possibilités inédites à ceux qui savent en profiter.

Par écran interposé, il nous observe, entre intérêt et perplexité. Dans sa série The Man Machine, l’artiste Vincent Fournier donne une étrange humanité à ces robots qui tentent – sans trop de succès – de s’intégrer dans notre société. | Photo: Reem B #7 [Pal], Barcelone, Spain, 2010. Vincent Fournier

«Le CERN a mené des expériences avec les réseaux neuronaux dans les années 90», note Sigve Haug du Laboratoire de physique des hautes énergies de l’Université de Berne. Mais on ne parlait à l’époque simplement pas encore de «machine learning».

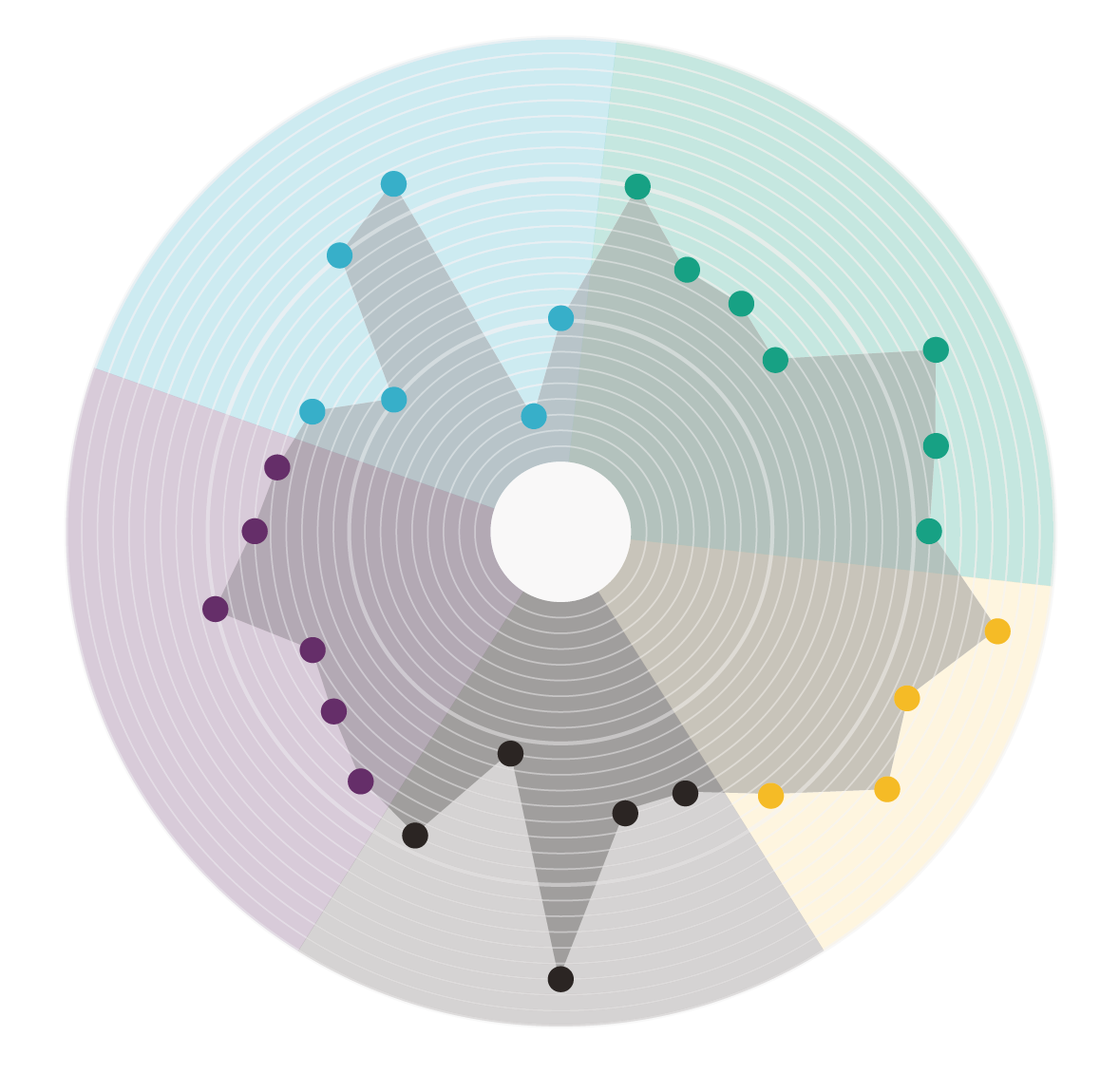

Aujourd’hui, le recours à l’IA dans les grandes expériences de physique des particules n’a plus rien d’extraordinaire, que ce soit pour l’analyse des données ou leur reconstruction. L’informatique distribuée l’utilise aussi régulièrement dans les programmes qui optimisent la répartition des tâches entre plusieurs centres de calcul. Mais l’IA n’est pas seulement omniprésente au CERN. On la retrouve désormais en chimie physique, biologie moléculaire, génétique médicale, astrophysique et humanités digitales. Partout où il y a du big data, des grandes quantités de données à traiter.

Faut-il se préparer à la prochaine étape, qui pourrait voire l’intelligence artificielle se glisser dans des assistants de laboratoire d’un nouveau genre et faire émerger des équipes composées d’hommes et de machines? «Absolument, avance Karsten Borgwardt du Machine Learning and Computational Biology Lab à ETH Zurich. On ne peut déjà plus s’en passer dans de nombreux domaines des sciences de la vie qui exigent de travailler avec des procédés à haut débit.» Comme découvrir des liens dans les données génétiques d’un demi-million de dossiers médicaux.

Les quantités de données deviennent tout simplement trop importantes, note le chercheur: «Personne n’est capable d’identifier à l’oeil nu une structure significative encore inconnue.» Face à de tels volumes d’informations, il est indispensable de développer des procédures d’analyse statistique efficace, à l’instar du jeune professeur. Pour lui, la frontière entre statistique et apprentissage automatique s’estompe toujours plus.

La science dopée

L’intelligence artificielle comme partenaire du chercheur: l’idée rappelle le concept de l’«Advanced Chess» formulé par Garry Kasparov peu après sa défaite contre Deep Blue il y a exactement vingt ans. Il estimait qu’à l’avenir, les parties ne devraient plus opposer des humains entre eux ou à un ordinateur, mais plutôt des équipes composées d’humains et de machines. Les échecs pourraient ainsi atteindre un tout autre niveau, bien au-delà des stratégies à portée de notre espèce.

«L’apprentissage automatique, c’est la science sous stéroïdes», écrit Pedro Domingos dans «The Master Algorithm». Le spécialiste en IA à l’Université de Washington y postule l’existence d’un algorithme d’apprentissage surpuissant capable de tout comprendre. Son utilisation intensive rendrait la recherche plus rapide, efficace et profonde. Libérés des procédures statistiques routinières, les scientifiques se concentreraient entièrement sur la composante créative de leur travail. Pour Pedro Domingos, il ne s’agit rien de moins que l’avènement d’un nouvel âge d’or des sciences.

Mais tous les chercheurs familiers de l’IA n’entonnent pas aveuglément ce type de louanges. Comme Neven Caplar de l’Institut d’astronomie d’ETH Zurich, un passionné des données: il leur consacre son blog astrodataiscool.com et a utilisé l’apprentissage automatique pour quantifier les biais sexistes dans les publications en astronomie. Le jeune chercheur constate bien une progression significative des publications liées à l’IA, mais il se demande encore si elle s’imposera dans son domaine de recherche. L’astronomie est «une science sujette à pleine de distorsions» où le contrôle des instruments joue un rôle essentiel. C’est pourquoi il faut éviter autant que possible d’en faire une boîte noire, un outil peut être pratique qui livre de bons résultats mais dont on ne comprend pas le fonctionnement. L’interprétation humaine continue de jouer un rôle central pour traiter les données issues d’observations, souligne Neven Caplar.

Un outil comme un autre

«Ah! ces boîtes noires!» s’exclame son collègue Kevin Schawinski (voir également «Galaxies citoyennes», p. 30). Tout le monde reproche à l’IA de ne pas nous permettre de comprendre la logique suivie, et de la remettre en question. Pas lui: «Je ne vois aucune boîte noire. Il s’agit simplement d’une méthode scientifique qu’il faut calibrer et tester pour bien la comprendre. Cela a toujours été le cas lorsque la science s’est approprié une nouvelle technique.» Après tout, aucun chercheur ne comprend dans leur intégralité des dispositifs expérimentaux aussi complexes que le Grand collisionneur de hadrons (LHC) du CERN ou le télescope Hubble. Il faut faire confiance à la communauté scientifique. Pour l’astrophysicien, elle devrait pouvoir bien s’assurer de la rigueur de la procédure, également dans le cas de l’intelligence artificielle.

Kevin Schawinski a lancé avec des informaticiens la plateforme Space.ml qui réunit un ensemble d’outils d’interprétation des données astronomiques faciles à utiliser. Il a mis au point une méthode pour optimiser des images de galaxies à l’aide d’un réseau de neurones afin d’en extraire davantage d’informations sans que l’ordinateur ait besoin d’instructions supplémentaires. D’autres applications demandent un apprentissage supervisé qui utilise des données d’entraînement. Choisies spécialement et étiquetées à la main, elles aident l’ordinateur à formuler lui-même des règles qui lui permettront d’exécuter une tâche.

Des algorithmes trop zélés

Le biostatisticien Karsten Borgwardt se sert par exemple de l’apprentissage supervisé pour découvrir si certaines modifications du génome pourraient avoir des effets néfastes sur l’organisme. Il nourrit l’ordinateur d’exemples déjà connus dans l’espoir qu’il trouvera de lui-même de nouvelles corrélations.

Mais un problème existe: l’overfitting. Il faut toujours se demander si l’ordinateur a reconnu des caractéristiques essentielles du système étudié ou si, au contraire, il finit par se noyer dans la mer de données et surinterprète ce qui ne sont en fait que de simples corrélations dues au hasard. Pour Pedro Domingos, l’apprentissage automatique se trouve toujours dans «un équilibre précaire entre aveuglement et hallucination»: l’algorithme risque soit de ne rien identifier soit de percevoir des choses qui n’existent pas – l’overfitting. Un système peut «trop apprendre», et tout entraînement supplémentaire ne fait qu’aggraver la situation.

Une des principales raisons de l’overfitting en génomique et en médecine vient d’un certain manque de transparence des données d’entraînement, explique Karsten Borgwardt. Cela empêche d’évaluer correctement dans quelle mesure elles correspondent à la situation concrète qu’on veut étudier. Si l’entraînement manque de variété, la machine ne parviendra peut-être pas à généraliser suffisamment. Ses recoupements ne correspondront qu’à un simple appris par coeur, et l’intelligence artificielle ne vaut pas mieux qu’une banque de données usuelle. Impossible dans ce cas de générer de nouvelles connaissances.

Même si tout fonctionne parfaitement durant la phase de formation, il faut encore distinguer les corrélations purement aléatoires de celles qui présentent une véritable signification statistique, poursuit Karsten Borgwardt. L’augmentation du volume de données génétiques accroît le risque de tomber sur des variantes du génome qui coïncident avec la présence d’une maladie mais sont en fait apparues suite au hasard. Une partie essentielle du travail consiste à identifier des indices statistiquement significatifs dans des espaces à dimensions extrêmement nombreuses. Autrement dit: être en mesure d’analyser rigoureusement aussi des situations très complexes et multifactorielles.

L’apprentissage automatique reste encore peu répandu en chimie physique mais suit une «progression rapide» dans ce domaine, relève Anatole von Lilienfeld de l’Université de Bâle. Ce spécialiste des matériaux estime que l’IA «constituera inévitablement une composante à part entière de la plupart des recherches dans dix ans».

Son groupe réalise un travail de pionnier: il a calculé grâce à l’IA les propriétés de millions de cristaux qui peuvent – en théorie – être construits à partir de quatre éléments de base. La machine a notamment identifié 90 structures inconnues à ce jour suffisamment stables du point de vue thermodynamique pour être intéressantes comme nouveaux matériaux potentiels. Même le spécialiste se dit impressionné par le gain d’efficacité engendré par l’IA dans le calcul des propriétés des cristaux, effectué par l’IA des millions de fois plus rapidement. Une amélioration telle qu’elle «permet non seulement de résoudre des problèmes conventionnels, mais ouvre carrément de nouveaux champs de recherche».

Le chimiste formule cependant lui aussi certaines réserves: l’apprentissage automatique ne fonctionne qu’en présence d’un principe défini de cause à effet, et lorsque suffisamment de données sont disponibles. Autre condition décisive: «Le chercheur doit posséder une expertise suffisante pour concevoir une représentation efficace du système étudié et de ses propriétés.»

Ce type d’expertise est également capital pour Guiseppe Carleo d’ETH Zurich. Le physicien théoricien a trouvé le moyen de reproduire grâce à un réseau de neurones la fonction d’onde de systèmes quantiques. Une fois ce pas franchi, son optimisation n’a représenté «qu’un jeu d’enfant». L’algorithme l’a effectuée rapidement et sans problème, alors que les méthodes traditionnelles atteignent vite leurs limites pour de tels volumes de calculs. La simulation de systèmes quantiques complexes semblait jusqu’à récemment «une chose impossible».

La nouvelle approche s’appuie sur la méthode de l’apprentissage non supervisé dans lequel l’ordinateur apprend sans bénéficier de savoir préalable. En physique théorique, elle permet de considérer «de vieux problèmes sous de nouvelles perspectives». Le physicien s’est d’ailleurs inspiré du triomphe de l’algorithme AlphaGo contre l’un des meilleurs joueurs de go mondiaux. Ce programme a progressé en menant d’innombrables parties contre lui-même et la méthode utilisée – l’apprentissage par renforcement – a projeté son intelligence stratégique dans des sphères totalement inédites.

Guiseppe Carleo a repris cette approche et l’a adaptée à ses objectifs. Pour simplifier, il a demandé à la machine de considérer le problème de la fonction d’onde comme un jeu dans lequel l’objectif est bien défini, mais le chemin pour l’atteindre est totalement libre. Elle devait apprendre d’elle-même à choisir les meilleures solutions. L’IA s’est prise au jeu. Au point qu’elle maîtrise désormais la physique quantique mieux que ceux qui l’ont développée.

Roland Fischer est journaliste libre et travaille à Berne.